Forwarded from Neural Shit

Там китайцы выкатили очередной text to image алгоритм: CogView. Трансформер на 4 миллиарда параметров + токенизатор VQ-VAE.

Тут демо версия алгоритма (к сожалению, сайт на китайском и принимает текстовые запросы только на китайском, переводчик в помощь). Ну и очередь на генерацию на сайте приличная. На изображениях выше примеры текстовых запросов и генерации изображений из них

Тут демо версия алгоритма (к сожалению, сайт на китайском и принимает текстовые запросы только на китайском, переводчик в помощь). Ну и очередь на генерацию на сайте приличная. На изображениях выше примеры текстовых запросов и генерации изображений из них

Milvus - Векторная база данных для хранения и поиска среди эмбеддингов!

Milvus is built on top of multiple optimized Approximate Nearest Neighbor Search (ANNS) indexing libraries, including faiss, annoy, hnswlib, etc.

https://github.com/milvus-io/milvus/

Milvus is built on top of multiple optimized Approximate Nearest Neighbor Search (ANNS) indexing libraries, including faiss, annoy, hnswlib, etc.

https://github.com/milvus-io/milvus/

GitHub

GitHub - milvus-io/milvus: Milvus is a high-performance, cloud-native vector database built for scalable vector ANN search

Milvus is a high-performance, cloud-native vector database built for scalable vector ANN search - milvus-io/milvus

Куда приводят мечты или рендеринг майкрафт мира с помощью GAN.

https://nvlabs.github.io/GANcraft/

https://github.com/NVlabs/imaginaire

https://arxiv.org/pdf/2104.07659v1.pdf

We present GANcraft, an unsupervised neural rendering framework for generating photorealistic images of large 3D block worlds such as those created in Minecraft. Our method takes a semantic block world as input, where each block is assigned a label such as dirt, grass, tree, sand, or water. We represent the world as a continuous volumetric function and train our model to render view-consistent photorealistic images from arbitrary viewpoints, in the absence of paired ground truth real images for the block world. In addition to camera pose, GANcraft allows user control over both scene semantics and style.

https://youtu.be/1Hky092CGFQ

https://nvlabs.github.io/GANcraft/

https://github.com/NVlabs/imaginaire

https://arxiv.org/pdf/2104.07659v1.pdf

We present GANcraft, an unsupervised neural rendering framework for generating photorealistic images of large 3D block worlds such as those created in Minecraft. Our method takes a semantic block world as input, where each block is assigned a label such as dirt, grass, tree, sand, or water. We represent the world as a continuous volumetric function and train our model to render view-consistent photorealistic images from arbitrary viewpoints, in the absence of paired ground truth real images for the block world. In addition to camera pose, GANcraft allows user control over both scene semantics and style.

https://youtu.be/1Hky092CGFQ

This media is not supported in your browser

VIEW IN TELEGRAM

Офигенно!)

Unsupervised 3D Neural Rendering of Minecraft Worlds

Unsupervised 3D Neural Rendering of Minecraft Worlds

Forwarded from DeepPavlov notifications

Пропустили итоговый семинар, на котором выступали участники курса с докладами по своим проектам?

Мы подготовили короткий обзор, с которым вы можете ознакомиться на Хабр.

https://habr.com/ru/company/ods/blog/514072/

Мы подготовили короткий обзор, с которым вы можете ознакомиться на Хабр.

https://habr.com/ru/company/ods/blog/514072/

Хабр

Итоговые проекты курса Deep Learning in Natural Language Processing (by DeepPavlov Lab)

Недавно завершился « Deep Learning in Natural Language Processing », открытый образовательный курс по обработке естественного языка. По традиции кураторы курса — сотрудники проекта DeepPavlov ,...

This media is not supported in your browser

VIEW IN TELEGRAM

Куча классных Vision Transformer для Pytorch в одном пакете.

https://github.com/lucidrains/vit-pytorch

https://github.com/lucidrains/vit-pytorch

PyTorchVideo мощная библиотека от facebook для задач с пониманием и анализом видео.

PytorchVideo provides reusable, modular and efficient components needed to accelerate the video understanding research. PyTorchVideo is developed using PyTorch and supports different deeplearning video components like video models, video datasets, and video-specific transforms.

Key features include:

Based on PyTorch: Built using PyTorch. Makes it easy to use all of the PyTorch-ecosystem components.

Reproducible Model Zoo: Variety of state of the art pretrained video models and their associated benchmarks that are ready to use. Complementing the model zoo, PyTorchVideo comes with extensive data loaders supporting different datasets.

Efficient Video Components: Video-focused fast and efficient components that are easy to use. Supports accelerated inference on hardware.

https://github.com/facebookresearch/pytorchvideo

PytorchVideo provides reusable, modular and efficient components needed to accelerate the video understanding research. PyTorchVideo is developed using PyTorch and supports different deeplearning video components like video models, video datasets, and video-specific transforms.

Key features include:

Based on PyTorch: Built using PyTorch. Makes it easy to use all of the PyTorch-ecosystem components.

Reproducible Model Zoo: Variety of state of the art pretrained video models and their associated benchmarks that are ready to use. Complementing the model zoo, PyTorchVideo comes with extensive data loaders supporting different datasets.

Efficient Video Components: Video-focused fast and efficient components that are easy to use. Supports accelerated inference on hardware.

https://github.com/facebookresearch/pytorchvideo

GitHub

GitHub - facebookresearch/pytorchvideo: A deep learning library for video understanding research.

A deep learning library for video understanding research. - facebookresearch/pytorchvideo

Еще одна модная векторая база данных для ML задач с трансформерами из коробки и GraphQL!

https://github.com/semi-technologies/weaviate

Weaviate in a nutshell: Weaviate is a vector search engine and vector database. Weaviate uses machine learning to vectorize and store data, and to find answers to natural language queries. With Weaviate you can also bring your custom ML models to production scale.

Weaviate in detail: Weaviate is a low-latency vector search engine with out-of-the-box support for different media types (text, images, etc.). It offers Semantic Search, Question-Answer-Extraction, Classification, Customizable Models (PyTorch/TensorFlow/Keras), and more. Built from scratch in Go, Weaviate stores both objects and vectors, allowing for combining vector search with structured filtering with the fault-tolerance of a cloud-native database, all accessible through GraphQL, REST, and various language clients.

https://github.com/semi-technologies/weaviate

Weaviate in a nutshell: Weaviate is a vector search engine and vector database. Weaviate uses machine learning to vectorize and store data, and to find answers to natural language queries. With Weaviate you can also bring your custom ML models to production scale.

Weaviate in detail: Weaviate is a low-latency vector search engine with out-of-the-box support for different media types (text, images, etc.). It offers Semantic Search, Question-Answer-Extraction, Classification, Customizable Models (PyTorch/TensorFlow/Keras), and more. Built from scratch in Go, Weaviate stores both objects and vectors, allowing for combining vector search with structured filtering with the fault-tolerance of a cloud-native database, all accessible through GraphQL, REST, and various language clients.

GitHub

GitHub - weaviate/weaviate: Weaviate is an open-source vector database that stores both objects and vectors, allowing for the combination…

Weaviate is an open-source vector database that stores both objects and vectors, allowing for the combination of vector search with structured filtering with the fault tolerance and scalability of ...

Forwarded from gonzo-обзоры ML статей

[OpenAI DALL·E] Zero-Shot Text-to-Image Generation

Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, Scott Gray, Chelsea Voss, Alec Radford, Mark Chen, Ilya Sutskever

Статья: https://arxiv.org/abs/2102.12092

Пост в блоге: https://openai.com/blog/dall-e/

Код (официальный, но неполный): https://github.com/openai/dall-e

Код (неофициальный, но более полный): https://github.com/lucidrains/DALLE-pytorch

Обученная модель от Сбера: https://github.com/sberbank-ai/ru-dalle

В последнее время появилось много мультимодальных трансформеров, и хочется их поразбирать. Нельзя обойти при этом наиболее известные модели, одна из которых — DALL·E от OpenAI.

DALL·E прошумел уже довольно давно, в самом начале года, но статья и все детали реализации стали доступны не сразу (в официальной репе так вообще лежит только обученный dVAE, который лишь часть от DALL·E).

Собственно, что такое DALL·E? Это декодер трансформера, который авторегрессионно умеет генерить изображения, “продолжая” заданное текстовое описание и, возможно, начальную часть изображения.

В оригинальном посте было заявлено, что это 12-миллиардная версия GPT-3, обученная на парах картинок и их описаний, но реальность сильно сложнее.

Начать стоит с того, что процесс обучения двухэтапный. На первом этапе обучается дискретный VAE (dVAE), сжимающий входную картинку 256*256 в картиночные токены на сетке 32*32, принимающие 8192 возможных значения каждый (то есть размер словаря). Это нужно для того, чтобы уменьшить количество токенов, с которыми должен дальше оперировать трансформер, и даёт уменьшение размера контекста в 192 раза. Часть высокочастотного сигнала в изображении при этом, ожидаемо, теряется, мелкие детали становятся плохо- или неразличимы, но в целом качество восстановления картинки после такого dVAE вполне достойно. Именно отсюда получается та самая своеобразная гладкость генеримых DALL·E картинок и проблемы с мелкими деталями, соответственно не для любого типа изображений DALL·E подходит, либо же процесс требует переобучения dVAE на более специальные кейсы. В dVAE никаких трансформеров нет, это свёрточный резнет.

Второй этап — это собственно трансформер. 256 кодирующих текст BPE-токенов (словарь размера 16384) конкатенируются с 1024 картиночными токенами, полученными от dVAE, и эта последовательность авторегрессионно продолжается. Сам трансформер это 64-слойный sparse transformer от тех же OpenAI (https://arxiv.org/abs/1904.10509). Он хитрый, в нём три типа шаблонов внимания: 1) text-to-text классический masked механизм как в авторегрессионных языковых моделях по типу GPT, где текущий токен не имеет права заглядывать в будущие токены; 2) image-to-text, где каждый токен изображения смотрит на все токены текста; и 3) image-to-image, где используются паттерны из sparse transformer с вниманием по строкам, столбцам и более хитрыми свёрточными шаблонами, которые применяются только в последнем self-attention слое. При этом все три типа заведены в одну единственную операцию внимания, потому что это работало лучше, чем три отдельные операции.

Авторы сначала экспериментировали на маленькой модели в 1.2B параметров и датасете в 3.3M пар картинка-текст, а потом отскейлили это на 12B модель и датасет в 250M пар (который пришлось собрать). Собственно этот скейлинг и составляет главные идейную и техническую часть работы. Идейно — показать, что обученная на большом датасете модель большого размера демонстрирует интересное поведение, а технически — заставить всё это работать, потому что вылезает много инженерных челленджей, не проявляющихся на меньших масштабах.

По признанию авторов, самая сложная часть проекта была в том, чтобы обучить большую модель на 16-битных числах (вместо обычных 32-битных). Было много всяких нестабильностей, поэтому авторы придумали хитрые методы масштабирования градиентов для защиты от underflow. Другой челлендж — распределённое обучение, где использовался тонко настроенный вариант PowerSGD. За этими (на самом деле важными, если хотите повторить) техническими деталями обращайтесь в Appendix.

Aditya Ramesh, Mikhail Pavlov, Gabriel Goh, Scott Gray, Chelsea Voss, Alec Radford, Mark Chen, Ilya Sutskever

Статья: https://arxiv.org/abs/2102.12092

Пост в блоге: https://openai.com/blog/dall-e/

Код (официальный, но неполный): https://github.com/openai/dall-e

Код (неофициальный, но более полный): https://github.com/lucidrains/DALLE-pytorch

Обученная модель от Сбера: https://github.com/sberbank-ai/ru-dalle

В последнее время появилось много мультимодальных трансформеров, и хочется их поразбирать. Нельзя обойти при этом наиболее известные модели, одна из которых — DALL·E от OpenAI.

DALL·E прошумел уже довольно давно, в самом начале года, но статья и все детали реализации стали доступны не сразу (в официальной репе так вообще лежит только обученный dVAE, который лишь часть от DALL·E).

Собственно, что такое DALL·E? Это декодер трансформера, который авторегрессионно умеет генерить изображения, “продолжая” заданное текстовое описание и, возможно, начальную часть изображения.

В оригинальном посте было заявлено, что это 12-миллиардная версия GPT-3, обученная на парах картинок и их описаний, но реальность сильно сложнее.

Начать стоит с того, что процесс обучения двухэтапный. На первом этапе обучается дискретный VAE (dVAE), сжимающий входную картинку 256*256 в картиночные токены на сетке 32*32, принимающие 8192 возможных значения каждый (то есть размер словаря). Это нужно для того, чтобы уменьшить количество токенов, с которыми должен дальше оперировать трансформер, и даёт уменьшение размера контекста в 192 раза. Часть высокочастотного сигнала в изображении при этом, ожидаемо, теряется, мелкие детали становятся плохо- или неразличимы, но в целом качество восстановления картинки после такого dVAE вполне достойно. Именно отсюда получается та самая своеобразная гладкость генеримых DALL·E картинок и проблемы с мелкими деталями, соответственно не для любого типа изображений DALL·E подходит, либо же процесс требует переобучения dVAE на более специальные кейсы. В dVAE никаких трансформеров нет, это свёрточный резнет.

Второй этап — это собственно трансформер. 256 кодирующих текст BPE-токенов (словарь размера 16384) конкатенируются с 1024 картиночными токенами, полученными от dVAE, и эта последовательность авторегрессионно продолжается. Сам трансформер это 64-слойный sparse transformer от тех же OpenAI (https://arxiv.org/abs/1904.10509). Он хитрый, в нём три типа шаблонов внимания: 1) text-to-text классический masked механизм как в авторегрессионных языковых моделях по типу GPT, где текущий токен не имеет права заглядывать в будущие токены; 2) image-to-text, где каждый токен изображения смотрит на все токены текста; и 3) image-to-image, где используются паттерны из sparse transformer с вниманием по строкам, столбцам и более хитрыми свёрточными шаблонами, которые применяются только в последнем self-attention слое. При этом все три типа заведены в одну единственную операцию внимания, потому что это работало лучше, чем три отдельные операции.

Авторы сначала экспериментировали на маленькой модели в 1.2B параметров и датасете в 3.3M пар картинка-текст, а потом отскейлили это на 12B модель и датасет в 250M пар (который пришлось собрать). Собственно этот скейлинг и составляет главные идейную и техническую часть работы. Идейно — показать, что обученная на большом датасете модель большого размера демонстрирует интересное поведение, а технически — заставить всё это работать, потому что вылезает много инженерных челленджей, не проявляющихся на меньших масштабах.

По признанию авторов, самая сложная часть проекта была в том, чтобы обучить большую модель на 16-битных числах (вместо обычных 32-битных). Было много всяких нестабильностей, поэтому авторы придумали хитрые методы масштабирования градиентов для защиты от underflow. Другой челлендж — распределённое обучение, где использовался тонко настроенный вариант PowerSGD. За этими (на самом деле важными, если хотите повторить) техническими деталями обращайтесь в Appendix.

Openai

DALL·E: Creating images from text

We’ve trained a neural network called DALL·E that creates images from text captions for a wide range of concepts expressible in natural language.

Начать разбираться в AI и ML — легко!

Смотрите, какой крутой проект — YouTube-канал "Академия искусственного интеллекта". Это совместный проект Сбера и Благотворительного фонда "Вклад в будущее". Цель проекта — помочь разобраться, что такое искусственный интеллект и машинное обучение. В коротких видео понятным языком рассказывают о новых веяниях ИИ, об олимпиадах, стажировках и хакатонах; а также дают много полезных ссылок и материалов, которые помогут лучше разобраться в теме.

Вот несколько интересных видео:

- Нейросеть DallE от Сбера: интервью с одним из создателей.

- Почему ИИ стоит изучать.

- Стажировка в Сбере.

- Как достичь успеха в data science и IT

В 2021 изученим AI и ML действительно стоит начать заниматься уже сейчас: чтобы не отодвигать изучение самой развивающейся сферы в мире и стать в ней первым!

Академия ИИ докажет вам, что AI — это суперувлекательно! Подписывайтесь

Смотрите, какой крутой проект — YouTube-канал "Академия искусственного интеллекта". Это совместный проект Сбера и Благотворительного фонда "Вклад в будущее". Цель проекта — помочь разобраться, что такое искусственный интеллект и машинное обучение. В коротких видео понятным языком рассказывают о новых веяниях ИИ, об олимпиадах, стажировках и хакатонах; а также дают много полезных ссылок и материалов, которые помогут лучше разобраться в теме.

Вот несколько интересных видео:

- Нейросеть DallE от Сбера: интервью с одним из создателей.

- Почему ИИ стоит изучать.

- Стажировка в Сбере.

- Как достичь успеха в data science и IT

В 2021 изученим AI и ML действительно стоит начать заниматься уже сейчас: чтобы не отодвигать изучение самой развивающейся сферы в мире и стать в ней первым!

Академия ИИ докажет вам, что AI — это суперувлекательно! Подписывайтесь

Вы руководите стартапом в сфере искусственного интеллекта или, может быть, работаете в секторе Интернета вещей или индустрии дополненной реальности? Нажмите здесь и узнайте, как вы можете воспользоваться программой Европейского Союза, не находясь в ЕС. Завоевать новых клиентов и новые контакты на европейском рынке. Ознакомьтесь с программой Poland Prize

https://technopark.kielce.pl/polandprizerus/

https://technopark.kielce.pl/polandprizerus/

Forwarded from Machine Learning Research

Объёдинённый репозиторий для BERT, GPT, GPT-2, Transfo-XL, XLNet, XLM. Всего 27 претренированных моделей

https://twitter.com/Thom_Wolf/status/1151169470498582529

https://twitter.com/Thom_Wolf/status/1151169470498582529

Twitter

Thomas Wolf

🔥Pytorch-Transformers 1.0🔥 Six NLU/NLG architectures: BERT, GPT, GPT-2, Transfo-XL, XLNet, XLM Total: 27 pretrained models Still the same -Superfast onboarding -SOTA noscripts: GLUE, SQuAD, Text generation New -Unified API -Access hidden-states, attentions...…

👍3

Forwarded from Python Lounge: работа и стажировки для программистов

15 Open Source библиотек для повышения качества данных

Open Source библиотеки Python, которые помогут вам сделать данные лучше, чтобы избежать траты времени и упростить анализ данных.

Статья

Open Source библиотеки Python, которые помогут вам сделать данные лучше, чтобы избежать траты времени и упростить анализ данных.

Статья

👍3

Forwarded from Denis Sexy IT 🤖

Настоящие революции в мире ML происходят не так часто — что случилось что-то серьезное, можно понять по сообщениям в твиттере от ML-инженеров в стиле: «У меня просто руки опускаются теперь что-то делать», «Я не вижу смысла продолжать свое исследование» и тп.

Речь идет о задаче генерации картинки по тексту, и я про новую версию DALL•E от OpenAI, о которой кажется все уже написали.

Нейронка может работать в трех режимах:

✨ Генерировать картинку с нуля;

✨ Дорисовывать часть картинки;

✨ Сгенерировать новые версии картинки на входе.

Упрощенно, на пальцах, довольно сложно рассказать как работает этот подход (потому что на фразе «диффузионный декодер и диффузионную визуальную модель» обычные люди начинают плакать), но я подумаю над простым объяснением, как я делал тут.

Ниже будет пост, где я собрал результаты генерации из разных твиттер тредов и дописал запросы по которым эти картинки генерировались (их никто не дорабатывал в фотошопе, это сырой выход из нейронки – в разрешении 1024х1024).

А вот так выглядит интерфейс для генерации, доступ к которому пока есть только у ~400 человек (я тоже подал заявку и в списке ожидания):

Речь идет о задаче генерации картинки по тексту, и я про новую версию DALL•E от OpenAI, о которой кажется все уже написали.

Нейронка может работать в трех режимах:

✨ Генерировать картинку с нуля;

✨ Дорисовывать часть картинки;

✨ Сгенерировать новые версии картинки на входе.

Упрощенно, на пальцах, довольно сложно рассказать как работает этот подход (потому что на фразе «диффузионный декодер и диффузионную визуальную модель» обычные люди начинают плакать), но я подумаю над простым объяснением, как я делал тут.

Ниже будет пост, где я собрал результаты генерации из разных твиттер тредов и дописал запросы по которым эти картинки генерировались (их никто не дорабатывал в фотошопе, это сырой выход из нейронки – в разрешении 1024х1024).

А вот так выглядит интерфейс для генерации, доступ к которому пока есть только у ~400 человек (я тоже подал заявку и в списке ожидания):

👍14💩1

Если вы хотите уметь решать Computer Vision задачи end-to-end, начиная от краудсорсинга данных, заканчивая автоматизацией деплоя, то записывайтесь на курс Ракета в Computer Vision от DeepSchool.

На курсе вы научитесь краудсорсить, быстро учить модели, ускорять сетки, создавать сервисы, автоматизировать их деплой, настраивать мониторинг и многое другое.

Переходите по ссылке, чтобы узнать программу и прочитать отзывы.

На курсе вы научитесь краудсорсить, быстро учить модели, ускорять сетки, создавать сервисы, автоматизировать их деплой, настраивать мониторинг и многое другое.

Переходите по ссылке, чтобы узнать программу и прочитать отзывы.

Системные знания и практику по Java не заменить информацией из интернета, а хорошие курсы стоят дорого, но!

В Kata Academy можно выучиться на Java-разработчика бесплатно, а заплатить уже после трудоустройства по специальности из фактической зарплаты.

Если задуматься, то все в выигрыше 👉

—Ты получаешь работу с хорошей зарплатой, мы получаем процент за инвестиции в тебя и продолжаем прокачивать твои навыки еще 2 года;

— в наших интересах научить тебя так, чтобы твоя зарплата была как можно выше;

— мы развиваем твои навыки и после курсов: проводим выездные мероприятия и мастер-классы — и доходы наших выпускников растут;

— мы не зависим от банков и их рассрочек — кризис не повлиял на доступность курсов.

Чтобы попасть на курс, нужно выполнить небольшое тестовое задание. Переходи по ссылке и оставляй заявку!

В Kata Academy можно выучиться на Java-разработчика бесплатно, а заплатить уже после трудоустройства по специальности из фактической зарплаты.

Если задуматься, то все в выигрыше 👉

—Ты получаешь работу с хорошей зарплатой, мы получаем процент за инвестиции в тебя и продолжаем прокачивать твои навыки еще 2 года;

— в наших интересах научить тебя так, чтобы твоя зарплата была как можно выше;

— мы развиваем твои навыки и после курсов: проводим выездные мероприятия и мастер-классы — и доходы наших выпускников растут;

— мы не зависим от банков и их рассрочек — кризис не повлиял на доступность курсов.

Чтобы попасть на курс, нужно выполнить небольшое тестовое задание. Переходи по ссылке и оставляй заявку!

👍2

Forwarded from Denis Sexy IT 🤖

This media is not supported in your browser

VIEW IN TELEGRAM

Наткнулся на совершенно фантастическое качество конвертации английского текста в голос нейронкой.

Если честно, в Open Source такого качества не видел пока что, и там много голосов, вот страница с примерами.

Вдруг кому-то полезно будет для проектов англоговорящих – алгоритм называется Tortoise:

🐢 Код | Колаб

Если честно, в Open Source такого качества не видел пока что, и там много голосов, вот страница с примерами.

Вдруг кому-то полезно будет для проектов англоговорящих – алгоритм называется Tortoise:

🐢 Код | Колаб

👍6

Forwarded from Denis Sexy IT 🤖

This media is not supported in your browser

VIEW IN TELEGRAM

Задачу генерации картинок из текста можно считать решенной — поэтому исследователи постепенно переходят к задаче «А давайте генерировать целые гифки по текстовому описанию».

Вчера выложили пример работы алгоритма CogVideo — суть у него такая же как у Dalle, вы пишите текст, а он выдает вам видео в 4 секунды длинной.

Кода пока нет, но по видимому будет тут.

У меня две мысли:

1) Лев который пьет — офигенный

2) Исследователи так порно индустрию без денег оставят своими нейронками

@Denis

Вчера выложили пример работы алгоритма CogVideo — суть у него такая же как у Dalle, вы пишите текст, а он выдает вам видео в 4 секунды длинной.

Кода пока нет, но по видимому будет тут.

У меня две мысли:

1) Лев который пьет — офигенный

2) Исследователи так порно индустрию без денег оставят своими нейронками

@Denis

🔥7👍5

Слышали о том, что анализ данных — востребованная сфера? Давайте разберёмся в профессии аналитика данных вместе.

Собрали всю базовую информацию о специальности в бесплатном гайде. За 10 минут чтения вы поймёте:

— какие задачи решает аналитик;

— кто такие и чем отличаются друг от друга джун, мидл и синьор;

— какие навыки и знания нужны для старта в профессии;

— как можно освоить профессию;

— как и куда расти джуну.

А ещё мы собрали полезные ссылки для начинающих аналитиков: где читать новости и узнавать новое.

Чтобы получить гайд, переходите по ссылке.

Собрали всю базовую информацию о специальности в бесплатном гайде. За 10 минут чтения вы поймёте:

— какие задачи решает аналитик;

— кто такие и чем отличаются друг от друга джун, мидл и синьор;

— какие навыки и знания нужны для старта в профессии;

— как можно освоить профессию;

— как и куда расти джуну.

А ещё мы собрали полезные ссылки для начинающих аналитиков: где читать новости и узнавать новое.

Чтобы получить гайд, переходите по ссылке.

Forwarded from Denis Sexy IT 🤖

Новый околонаучный дайджест за эту неделю:

🗑 Не успели мы освоить другую планету, как уже начали на ней мусорить. Вот, например, на Марсе Perseverance нашел странную штуку, которая оказалась термоматериалом, застрявшем в камне. Его отнесло от места посадки на 2 км марсианским ветром (Rus / Eng)

🐕 Ghost Robotics (это которые военные робо-псы) разработала модуль для перемещения пёсика вплавь со скоростью 3 узла (это примерно 1,5 м/с), он просто ложится в воду и поджимает лапы, после чего начинает работать реактивный двигатель (Eng)

📡 Израильская фирма Camero-Tech говорит, что разработала портативную систему обработки изображений, которая может «видеть» сквозь стены. Радар работает, естественно, с ИИ и отслеживает живые цели в 3D, короче штука для военных (Rus / Eng)

🥶 Зоологи выяснили, что в Гренландии есть изолированные медведи «отшельники», которые научились выживать в условиях нехватки морского льда. В качестве опоры в летний период они используют пресный лёд, который сползает с ледников в море (Rus / Eng)

🟡 Учёные выяснили, что скорость и направление вращения Земного ядра меняется со временем, то есть на основе компьютерных моделей было определено, что оно вращается то в одном, то в другом направлении с изменяющейся скоростью (Rus / Eng)

🕸 Очередной эпик про глубокий космос — с помощью радиотелескопа ALMA астрономы обнаружили в огромной области звездообразования реальную сеть из связанных нитей холодного молекулярного газа. В общем, даже в таких условиях процесс рождения новых звёзд идёт весьма эффективно, в источнике фото/видео (Rus / Eng)

🔭 Никогда бы не подумал что такое возможно, но в Индии запустили новый телескоп с главным зеркалом из жидкой ртути, 50 литров находятся внутри четырёхметрового параболического зеркала (Rus / Eng)

🎲 Youtube канал о науке вдохновил физиков на проверку эффекта домино. Они смоделировали падение выстроенных костяшек, где учитывали все тонкости, вплоть до силы трения пластика об поверхность и объяснили редкие аномалии, связанные со спонтанной остановкой волны (Rus / Eng)

Дайджест событий прошлой недели тут.

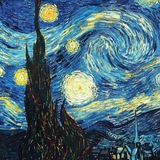

На картинке медведь-отшельник готовит себе ужин, спасибо Dalle:

🗑 Не успели мы освоить другую планету, как уже начали на ней мусорить. Вот, например, на Марсе Perseverance нашел странную штуку, которая оказалась термоматериалом, застрявшем в камне. Его отнесло от места посадки на 2 км марсианским ветром (Rus / Eng)

🐕 Ghost Robotics (это которые военные робо-псы) разработала модуль для перемещения пёсика вплавь со скоростью 3 узла (это примерно 1,5 м/с), он просто ложится в воду и поджимает лапы, после чего начинает работать реактивный двигатель (Eng)

📡 Израильская фирма Camero-Tech говорит, что разработала портативную систему обработки изображений, которая может «видеть» сквозь стены. Радар работает, естественно, с ИИ и отслеживает живые цели в 3D, короче штука для военных (Rus / Eng)

🥶 Зоологи выяснили, что в Гренландии есть изолированные медведи «отшельники», которые научились выживать в условиях нехватки морского льда. В качестве опоры в летний период они используют пресный лёд, который сползает с ледников в море (Rus / Eng)

🟡 Учёные выяснили, что скорость и направление вращения Земного ядра меняется со временем, то есть на основе компьютерных моделей было определено, что оно вращается то в одном, то в другом направлении с изменяющейся скоростью (Rus / Eng)

🕸 Очередной эпик про глубокий космос — с помощью радиотелескопа ALMA астрономы обнаружили в огромной области звездообразования реальную сеть из связанных нитей холодного молекулярного газа. В общем, даже в таких условиях процесс рождения новых звёзд идёт весьма эффективно, в источнике фото/видео (Rus / Eng)

🔭 Никогда бы не подумал что такое возможно, но в Индии запустили новый телескоп с главным зеркалом из жидкой ртути, 50 литров находятся внутри четырёхметрового параболического зеркала (Rus / Eng)

🎲 Youtube канал о науке вдохновил физиков на проверку эффекта домино. Они смоделировали падение выстроенных костяшек, где учитывали все тонкости, вплоть до силы трения пластика об поверхность и объяснили редкие аномалии, связанные со спонтанной остановкой волны (Rus / Eng)

Дайджест событий прошлой недели тут.

На картинке медведь-отшельник готовит себе ужин, спасибо Dalle:

👍4