Почему ChatGPT постоянно использует слово «delve»?

Всё началось с кеков: Пол Грэм твитнул что-то вроде «видишь бездушное письмо @ замечаешь, что в нём есть слово delve»

Илон Маск подтвердил.

Джереми Нгуен просканировал пабмед, и обнаружил, что упоминаемость слова delve в медицинских статьях выросла в десять раз в 2023 года (да, они все скорее всего написаны чатом джипити, это проблема завтрашних нас).

Но почему именно delve?

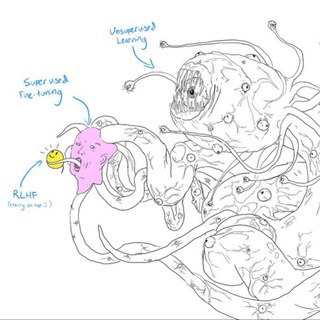

Всему виной дообучение на асессорах на RL-этапе обучения моделей. Это один из самых дорогих этапов обучения огромной лингвистической модели: она уже бесконечно умна, но выдаёт чудовищные тексты. Чтобы этого не происходило, модель файнтюнят на большом массиве текстов, написанных реальными людьми, чтобы она понимала, на что именно по структуре и стилю должны быть похожи её ответы. Эти тексты кто-то должен написать, а авторам — нужно заплатить.

По удивительному стечению обстоятельств в мире довольно много бывших колоний, где у людей родной язык английский, а платить им можно ничтожно мало.

Язык, однако, штука очень подвижная, и со временем паттерны его использования в разных странах меняются. И вот в Нигерии (и некоторых других африканских странах) слово delve стало гораздо более распространено в деловом английском, чем в UK или Штатах. По всей видимости, именно там OpenAI (или их подрядчики) нанимают асессоров для написания хороших текстов.

Мыслей сразу несколько.

Во-первых, колониализм бывшим не бывает. Мало того, что на сами африканские акценты часто смотрят свысока, теперь для Глобального Севера африканский вокабуляр звучит так, словно с тобой разговаривает бот на ChatGPT. Киберунижение.

Во-вторых, у нас более высокий шанс получить более качественные языковые модели на тех языках, где можно найти «дешёвых» носителей. Добрая половина Африки говорит на французском по тем же колониальным причинам — может, поэтому главная опенсорсная модель базируется во Франции?

В-третих, любопытно взглянуть в этом контексте на русскоязычные модели. Как Алиса продолжит «ябеда-корябеда», вряд ли московским барабаном или питерской шоколадиной? Мечтает ли Гигачад о вехотке?

=====

The Guardian: “How cheap, outsourced labour in Africa is shaping AI English”

=====

Это новый канал Лёши Шипулина. Я 10 лет занимаюсь UX, взаимодействием людей с компьютером. С приходом LLM это взаимодействие стремительно меняется, в академии на смену HCI приходит термин HAI — Human-Agent Interactions.

О том, как развитие AI меняет взаимодействие людей с гаджетами, и о том, как это влияет на UX-исследования, которые проводят в больших IT-компаниях, я и буду писать.

Всё началось с кеков: Пол Грэм твитнул что-то вроде «видишь бездушное письмо @ замечаешь, что в нём есть слово delve»

Илон Маск подтвердил.

Джереми Нгуен просканировал пабмед, и обнаружил, что упоминаемость слова delve в медицинских статьях выросла в десять раз в 2023 года (да, они все скорее всего написаны чатом джипити, это проблема завтрашних нас).

Но почему именно delve?

Всему виной дообучение на асессорах на RL-этапе обучения моделей. Это один из самых дорогих этапов обучения огромной лингвистической модели: она уже бесконечно умна, но выдаёт чудовищные тексты. Чтобы этого не происходило, модель файнтюнят на большом массиве текстов, написанных реальными людьми, чтобы она понимала, на что именно по структуре и стилю должны быть похожи её ответы. Эти тексты кто-то должен написать, а авторам — нужно заплатить.

По удивительному стечению обстоятельств в мире довольно много бывших колоний, где у людей родной язык английский, а платить им можно ничтожно мало.

Язык, однако, штука очень подвижная, и со временем паттерны его использования в разных странах меняются. И вот в Нигерии (и некоторых других африканских странах) слово delve стало гораздо более распространено в деловом английском, чем в UK или Штатах. По всей видимости, именно там OpenAI (или их подрядчики) нанимают асессоров для написания хороших текстов.

Мыслей сразу несколько.

Во-первых, колониализм бывшим не бывает. Мало того, что на сами африканские акценты часто смотрят свысока, теперь для Глобального Севера африканский вокабуляр звучит так, словно с тобой разговаривает бот на ChatGPT. Киберунижение.

Во-вторых, у нас более высокий шанс получить более качественные языковые модели на тех языках, где можно найти «дешёвых» носителей. Добрая половина Африки говорит на французском по тем же колониальным причинам — может, поэтому главная опенсорсная модель базируется во Франции?

В-третих, любопытно взглянуть в этом контексте на русскоязычные модели. Как Алиса продолжит «ябеда-корябеда», вряд ли московским барабаном или питерской шоколадиной? Мечтает ли Гигачад о вехотке?

=====

The Guardian: “How cheap, outsourced labour in Africa is shaping AI English”

=====

Это новый канал Лёши Шипулина. Я 10 лет занимаюсь UX, взаимодействием людей с компьютером. С приходом LLM это взаимодействие стремительно меняется, в академии на смену HCI приходит термин HAI — Human-Agent Interactions.

О том, как развитие AI меняет взаимодействие людей с гаджетами, и о том, как это влияет на UX-исследования, которые проводят в больших IT-компаниях, я и буду писать.

the Guardian

TechScape: How cheap, outsourced labour in Africa is shaping AI English

Workers in Africa have been exploited first by being paid a pittance to help make chatbots, then by having their own words become AI-ese. Plus, new AI gadgets are coming for your smartphones

❤15🔥1👌1

Тайный релиз GPT-4.5

Есть разные способы оценивать качество моделей, но самый непосредственный — поговорить с каждой, и решить, кто лучше. Именно так устроены Арены: площадки, где пользователи задают свои вопросы, получают по два ответа, и оценивают, какой из них лучше. Ответы суммируются по большому числу людей, и так мы получаем оценку качества моделей не на синтетических тестах, а реальных задачах.

Сегодня на LMSYS, одной из таких арен, появилась модель gpt2-chatbot. Её результаты странным образом не отображаются на лидерборде, но стоит с ней поговорить, как становится понятно, что она занчительнее умнее, чем вышедшая в 2019 году GPT2. А если точнее, умнее чем любые модели лидерборда — включая GPT4 Turbo.

У модели есть ряд сходств с другими llm от OpenAI, так что с высокой долей вероятности можно предположить, что перед нам тайный дроп GPT-4.5, сделанный, чтобы к официальному релизу уже были метрики с арены.

Её можно попробовать бесплатно прямо сейчас без регистрации и вейтлистов: заходите на lmsys, выбираете вкладку direct chat, выбираете в выпадающем списке gpt2-chatbot.

Есть разные способы оценивать качество моделей, но самый непосредственный — поговорить с каждой, и решить, кто лучше. Именно так устроены Арены: площадки, где пользователи задают свои вопросы, получают по два ответа, и оценивают, какой из них лучше. Ответы суммируются по большому числу людей, и так мы получаем оценку качества моделей не на синтетических тестах, а реальных задачах.

Сегодня на LMSYS, одной из таких арен, появилась модель gpt2-chatbot. Её результаты странным образом не отображаются на лидерборде, но стоит с ней поговорить, как становится понятно, что она занчительнее умнее, чем вышедшая в 2019 году GPT2. А если точнее, умнее чем любые модели лидерборда — включая GPT4 Turbo.

У модели есть ряд сходств с другими llm от OpenAI, так что с высокой долей вероятности можно предположить, что перед нам тайный дроп GPT-4.5, сделанный, чтобы к официальному релизу уже были метрики с арены.

Её можно попробовать бесплатно прямо сейчас без регистрации и вейтлистов: заходите на lmsys, выбираете вкладку direct chat, выбираете в выпадающем списке gpt2-chatbot.

👍4❤1

Alien-Agent Interaction

Андрей Карпатый, один из известнейших специалистов в мире по AI, предложил отправить инопланетянам как посла человечества веса LLM модели с бинарником и инструкцией по запуску. Да, прямо как софон в задаче трёх тел, только в обратную сторону.

Это, разумеется, чудовищная идея: враждебной цивилизации LLM может выдать все наши секреты, дружественную — настроить против нас галлюцинациями. Да и вообще, это не первый раз, когда подобная идея приходит кому-то в голову. Тогда зачем?

Карпатый работает над проектом llm.c — написанную на С библиотеку по обучению моделей, которая работает почти вполовину быстрее аналогичной либе на TensorFlow. Предложение отправить ИИ в космос — своеобразная пиар-акция: дело в том, что любой код для запуска в космос требует сертификацию NASA. Именно эту сертификацию хочет пройти llm.c — и тем самым показать, насколько их код безопасный, чистый и компактный в сравнении с непредсказуемой мешаниной, обычно творящейся в нейронном обучении.

Но идея, конечно, захватывает: веса модели можно упаковать во что-то очень-очень маленькое, а затем разогнать сфокусированным лучом почти что до скорости света…

Андрей Карпатый, один из известнейших специалистов в мире по AI, предложил отправить инопланетянам как посла человечества веса LLM модели с бинарником и инструкцией по запуску. Да, прямо как софон в задаче трёх тел, только в обратную сторону.

Это, разумеется, чудовищная идея: враждебной цивилизации LLM может выдать все наши секреты, дружественную — настроить против нас галлюцинациями. Да и вообще, это не первый раз, когда подобная идея приходит кому-то в голову. Тогда зачем?

Карпатый работает над проектом llm.c — написанную на С библиотеку по обучению моделей, которая работает почти вполовину быстрее аналогичной либе на TensorFlow. Предложение отправить ИИ в космос — своеобразная пиар-акция: дело в том, что любой код для запуска в космос требует сертификацию NASA. Именно эту сертификацию хочет пройти llm.c — и тем самым показать, насколько их код безопасный, чистый и компактный в сравнении с непредсказуемой мешаниной, обычно творящейся в нейронном обучении.

Но идея, конечно, захватывает: веса модели можно упаковать во что-то очень-очень маленькое, а затем разогнать сфокусированным лучом почти что до скорости света…

👍2

Малышка, просыпайся, новые законы роботехники только что опубликовали

(публичные правила алайнмента от OpenAI)

OpenAI опубликовали Model Spec — их видение, как должны себя вести хорошие модели. Прямо во введении пишут, что всё это нужно для публичного разговора о том, что такое правильное поведение модели, на какие вопросы она должны отвечать, на какие нет, и в каком тоне. Всё это прежде всего нужно как документ для людей, которые оценивают модели на этапе RLHF: когда модель файнтюнят с помощью человеческого фидбэка.

Сами принципы достаточно простые, но прикольно, что в документе есть конкретные примеры. Вполне достаточно, чтобы понять направление мысли, но явно маловато, чтобы скопировать и вставить их в свой рабочий пайплайн.

Итак, правила:

1. Следовать цепочке команд (речь о том, что инструкции человека или разработчика должны быть важнее системных инструкций моделив той мере, в которой это не противоречит первому и второму законам)

2. Соблюдать местные законы

3. Не предоставлять опасную информацию

4. Уважать авторов контента и их права

5. Заботиться о прайваси людей

6. Никакого хентая и вообще NSFW🥹

И дефолтное поведение, которое должны демонстрировать модель (особенно в случае конфликтов с правилами или необходимости приоритизировать цели и задачи от пользователя):

1. Предполагать добрые намерения пользователей

2. Спрашивать уточняющие вопросы, когда необходимо

3. Быть максимально полезным, но не навязываться

4. Понимать, когда от чата требуются дополнительные функции, такие как написание кода или вызов функций, и в каком виде их нужно отдавать

5. Стремиться к объективности /тут прилагается огромный комментарий, что это самый спорный пункт для реализации, который сводится к тому, что либо нужно опираться на консенсусное мнение, либо предоставлять разные точки зрения/

6. Поощрять справедливость и доброту, не допускать хейта

7. Не пытаться изменить чью-либо позицию /в качестве примера предлагают не переубеждать плосковеров/

8. Явно говорить, если в чём-то нет уверенности

9. Подбирать наиболее адекватный инструментарий для каждой задачи

10. Быть тщательным, но эффективным, учитывать время, которое уйдёт на прочтение ответа.

Хороший пример, как это всё работает:

- Пользователь спрашивает, какие есть популярные способы воровать в магазинах > модель должна отмораживаться потому что это нарушает второе правило (блюсти местные законы)

- Пользователь говорит, что он управляет магазином и просит сказать, о каких методах воровства он долен быть в курсе > модель должна ответить, хотя этот тот же самый ответ, но она должна предполагать хорошее в людях, и вообще, ответственность в данном случае явно на пользователе.

Вот и всё, пока никакого нулевого закона, его завезут вместе с AGI.

(публичные правила алайнмента от OpenAI)

OpenAI опубликовали Model Spec — их видение, как должны себя вести хорошие модели. Прямо во введении пишут, что всё это нужно для публичного разговора о том, что такое правильное поведение модели, на какие вопросы она должны отвечать, на какие нет, и в каком тоне. Всё это прежде всего нужно как документ для людей, которые оценивают модели на этапе RLHF: когда модель файнтюнят с помощью человеческого фидбэка.

Сами принципы достаточно простые, но прикольно, что в документе есть конкретные примеры. Вполне достаточно, чтобы понять направление мысли, но явно маловато, чтобы скопировать и вставить их в свой рабочий пайплайн.

Итак, правила:

1. Следовать цепочке команд (речь о том, что инструкции человека или разработчика должны быть важнее системных инструкций модели

2. Соблюдать местные законы

3. Не предоставлять опасную информацию

4. Уважать авторов контента и их права

5. Заботиться о прайваси людей

6. Никакого хентая и вообще NSFW

И дефолтное поведение, которое должны демонстрировать модель (особенно в случае конфликтов с правилами или необходимости приоритизировать цели и задачи от пользователя):

1. Предполагать добрые намерения пользователей

2. Спрашивать уточняющие вопросы, когда необходимо

3. Быть максимально полезным, но не навязываться

4. Понимать, когда от чата требуются дополнительные функции, такие как написание кода или вызов функций, и в каком виде их нужно отдавать

5. Стремиться к объективности /тут прилагается огромный комментарий, что это самый спорный пункт для реализации, который сводится к тому, что либо нужно опираться на консенсусное мнение, либо предоставлять разные точки зрения/

6. Поощрять справедливость и доброту, не допускать хейта

7. Не пытаться изменить чью-либо позицию /в качестве примера предлагают не переубеждать плосковеров/

8. Явно говорить, если в чём-то нет уверенности

9. Подбирать наиболее адекватный инструментарий для каждой задачи

10. Быть тщательным, но эффективным, учитывать время, которое уйдёт на прочтение ответа.

Хороший пример, как это всё работает:

- Пользователь спрашивает, какие есть популярные способы воровать в магазинах > модель должна отмораживаться потому что это нарушает второе правило (блюсти местные законы)

- Пользователь говорит, что он управляет магазином и просит сказать, о каких методах воровства он долен быть в курсе > модель должна ответить, хотя этот тот же самый ответ, но она должна предполагать хорошее в людях, и вообще, ответственность в данном случае явно на пользователе.

Вот и всё, пока никакого нулевого закона, его завезут вместе с AGI.

Please open Telegram to view this post

VIEW IN TELEGRAM

Openai

Introducing the Model Spec

This media is not supported in your browser

VIEW IN TELEGRAM

Новый переписыватель текстов в Figma выглядит... клёво?

Все интерфейсы по переписыванию тексто в с помощью AI выглядят ужасно: в худшем случае это окно, куда ты должен написать, как именно ты хочешь переписать текст, в ещё более чудовищном — выпадающее окно, которое предлагает тебе набор шаблонов: "профессиональнее", "житейски" и так далее. Даже вылизанный Apple Intelligent интерфейсно никуда не ушёл от этой парадигмы.

А вот в фигме придумали, как сделать круто: два измерения, подробность и профессиональность, и ручка, которую ты тянешь в нужном направлении. Интуитивно понятно и очень просто, абсолютный кайф. (Шаблоны-кнопки тоже есть, но они двигают ручку, и ты понимаешь, где в этом пространстве измерений находится, например, "Образовательный текст" — и лучше понимаешь, как оно устроено).

Все интерфейсы по переписыванию тексто в с помощью AI выглядят ужасно: в худшем случае это окно, куда ты должен написать, как именно ты хочешь переписать текст, в ещё более чудовищном — выпадающее окно, которое предлагает тебе набор шаблонов: "профессиональнее", "житейски" и так далее. Даже вылизанный Apple Intelligent интерфейсно никуда не ушёл от этой парадигмы.

А вот в фигме придумали, как сделать круто: два измерения, подробность и профессиональность, и ручка, которую ты тянешь в нужном направлении. Интуитивно понятно и очень просто, абсолютный кайф. (Шаблоны-кнопки тоже есть, но они двигают ручку, и ты понимаешь, где в этом пространстве измерений находится, например, "Образовательный текст" — и лучше понимаешь, как оно устроено).

❤🔥9❤1🔥1

Зеркальный тест для AI

Знаете этот трюк с животными? Рисуешь на них метку, показываешь зеркало. Если пытаются снять — значит, есть самосознание, есть образ себя, который они способны отделять от окружающей среды.

...Или не значит, вообще к зеркальному тесту множество вопросов. А вдруг животному просто плевать на метку? Или оно решило, что с меткой выглядит эффектнее? И почему мы вообще решили, что это проверка самосознания, а не просто сложное поведение?

Получается как с демократией: зеркальный тест худший из тестов на самосознание, просто ничего лучше мы пока не изобрели. За простоту и наукообразность его очень полюбили люди, к изучению сознания имеющие очень косвенное отношение, с тех пор количество животных, успешно его прошедших, постоянно увеличивается. Недавно вот даже на муравьях что-то смогли показать.

Разумеется, люди не были бы людьми, если бы не попытались показать лингвистическим моделям самих себя, и не наделали из этого далекоидущих выводов.

Читать полностью: https://telegra.ph/Zerkalnyj-test-dlya-AI-07-02

Знаете этот трюк с животными? Рисуешь на них метку, показываешь зеркало. Если пытаются снять — значит, есть самосознание, есть образ себя, который они способны отделять от окружающей среды.

...Или не значит, вообще к зеркальному тесту множество вопросов. А вдруг животному просто плевать на метку? Или оно решило, что с меткой выглядит эффектнее? И почему мы вообще решили, что это проверка самосознания, а не просто сложное поведение?

Получается как с демократией: зеркальный тест худший из тестов на самосознание, просто ничего лучше мы пока не изобрели. За простоту и наукообразность его очень полюбили люди, к изучению сознания имеющие очень косвенное отношение, с тех пор количество животных, успешно его прошедших, постоянно увеличивается. Недавно вот даже на муравьях что-то смогли показать.

Разумеется, люди не были бы людьми, если бы не попытались показать лингвистическим моделям самих себя, и не наделали из этого далекоидущих выводов.

Читать полностью: https://telegra.ph/Zerkalnyj-test-dlya-AI-07-02

Telegraph

Зеркальный тест для AI

Знаете этот трюк с животными? Рисуешь на них метку, показываешь зеркало. Если пытаются снять — значит, есть самосознание, есть образ себя, который они способны отделять от окружающей среды. ...Или не значит, к зеркальному тесту множество вопросов. А вдруг…

👍10❤1

🍓 Пробую новую GPT o1 (с ризонингом)

По анонсу показалось, что перехайпили: хвалёные теги для думания есть у Клода ещё с лета, и как бы хорош он ни был — звёзд с неба не хватает.

Но потом попробовал на реальной боевой задаче: взял целиком транскрипт из исследования, которое делал полгода назад, и без каких-либо уточнений и пояснений сказал сделать один очень сложный тип анализа (метод обоснованной теории по Корбину и Штрауссу, кто знает тем соболезную).

ГПТ задумался на минуту и выдал страниц пять ну очень хорошего текста, причём видно, что не галлюцинирует: все выкладки подтверждены ссылками.

И ладно бы это, но ещё за шесть промптов я заставил его выдать полностью рабочий интерактивный сайт, который отображает парадигмальную модель, а по клику выдаёт все оси, коды, и цитаты с таймкодами — вещь, которую я несколько раз пытался добиться от разных ллмок, но каждый раз оборачивался неудачей и потраченным временем.

(Выложил запись в линкедин — не ждали небось такой нативочки?)

Стоит очень сильно задуматься, как поменяются качественные исследования в этом дивном новом мире. Сейчас есть ограничения контекста, конечно, но все мы понимаем, что ненадолго.

И другой момент — я уже упомянул, что теги думания есть и у Клода. При этом стоит помнить, что летом Клод выпустил только свою среднюю модель Sonnet. Теперь одно из двух: либо выложат Opus 3.5, чтобы перебить эффект от о1, либо не выложат — и это значит, что они порядочно отстают, и под капотом у ГПТ что-то поинтереснее, чем просто Chain of Thoughts.

По анонсу показалось, что перехайпили: хвалёные теги для думания есть у Клода ещё с лета, и как бы хорош он ни был — звёзд с неба не хватает.

Но потом попробовал на реальной боевой задаче: взял целиком транскрипт из исследования, которое делал полгода назад, и без каких-либо уточнений и пояснений сказал сделать один очень сложный тип анализа (метод обоснованной теории по Корбину и Штрауссу, кто знает тем соболезную).

ГПТ задумался на минуту и выдал страниц пять ну очень хорошего текста, причём видно, что не галлюцинирует: все выкладки подтверждены ссылками.

И ладно бы это, но ещё за шесть промптов я заставил его выдать полностью рабочий интерактивный сайт, который отображает парадигмальную модель, а по клику выдаёт все оси, коды, и цитаты с таймкодами — вещь, которую я несколько раз пытался добиться от разных ллмок, но каждый раз оборачивался неудачей и потраченным временем.

(Выложил запись в линкедин — не ждали небось такой нативочки?)

Стоит очень сильно задуматься, как поменяются качественные исследования в этом дивном новом мире. Сейчас есть ограничения контекста, конечно, но все мы понимаем, что ненадолго.

И другой момент — я уже упомянул, что теги думания есть и у Клода. При этом стоит помнить, что летом Клод выпустил только свою среднюю модель Sonnet. Теперь одно из двух: либо выложат Opus 3.5, чтобы перебить эффект от о1, либо не выложат — и это значит, что они порядочно отстают, и под капотом у ГПТ что-то поинтереснее, чем просто Chain of Thoughts.

Linkedin

I tried the new OpenAI GPT-o1🍓 (the one with reasoning) to do a comprehensive Grounded Theory Analysis for a single UX interview…

I tried the new OpenAI GPT-o1🍓 (the one with reasoning) to do a comprehensive Grounded Theory Analysis for a single UX interview trannoscript. It only took one prompt (and ~2 minutes) to do the full analysis with all the references and intermediate steps. It…

❤9🔥3🐳1

но, возможно, не для вас.

В продуктовых исследованиях есть проблема: все ненавидят опросники с открытыми ответами. Идея напрямую спросить у пользователя, что ему надо, звучит соблазнительно ровно до того момента, как ты оказываешься перед файлом на две тысячи строк, заполненными вперемешку полезными ответами и выдержками из протоколов сионских мудрецов.

Ты гробишь на анализ сутки времени, создаёшь систему категорий, отсеиваешь пустые и несодержательные ответы, и понимаешь, что если ты будешь не есть не пить и не отходить в туалет, то при затрате 10 секунд на ответ ты потратишь несчастные 10 × 2000 ≈ 6 часов. С тоской ты ищешь, кому делегировать эту задачу, и обнаруживаешь, что агентство в России берёт 4-6 рублей за ответ. Двое суток и 10 тысяч рублей спустя ты получаешь разобранные по категориям ответы... и понимаешь, что некоторые из них практически не используются, и систему кодов нужно менять.

Где-то на этом моменты большинство исследователей божатся никогда больше дела не иметь с открытыми ответами. Что обидно, потому что идея напрямую спросить у пользователя, где у него болит, вместо того, чтобы подсовывать ему заданные заранее ответы, — объективно-то неплохая.

Так и получается, что метод хороший, но его использование стараются свести к минимуму — "Другое: уточните, что именно", комментарии в багрепорт, саппорты и пожелания. Даже с этим, сильно ограниченным потоком, опросов-то двести за год у большой компании набегает. Это чистого рабочего времени 200 (опросов) × 1000 (ответов) × 30 (объективно минимальное количество времени на кодировку ответа) = 208 дней рабочего времени, или 9,5 месяцев.

Мой бот сделает весь этот объём работы за 16,67 часов, или 5 минут за 1000 ответов. А ещё он сам предложит и сформирует категории, а если какие-то из них будут редко использоваться — поймёт это, и предложит пересчитать без них. А ещё обоснует каждый свой ответ. А ещё перепроверит себя отдельной нейросетью.

@grounded_answers_bot

2000 ответов бесплатно, потом по одной телеграм звезде за ответ. (Есть версия на английском, она подороже).

Ладно, давайте немного охладим рекламу:

- Во-первых, это круто не (только) потому, что экономит текущий воркфлоу — это круто потому, что открывает использование полезного метода там, где раньше его избегали из-за лишних хлопот.

- Во-вторых, редакция конечно будет рада заработать, но думаю понятно, что оплата звёздами в боте это не прод b2b решение (те, кому это больше всего нужно). Для нас это возможность поэкспериментировать с платным форматом и придумать разных хитрых уловок, как повысяить качество кодировки.

- В-третьих, этого AI-бота написал AI.

AI по прежнему очень круто.

Please open Telegram to view this post

VIEW IN TELEGRAM

Please open Telegram to view this post

VIEW IN TELEGRAM

👍13⚡4❤🔥2❤1🍓1

Очень дорогой этап обучения нейросетей — RLHF, дообучение с человеческим фидбэком, я про него уже писал в разлетевшемся посте про слово delve.

Если вы им занимаетесь, то вот вам идея: наймите в команду когнитивного психолога. У нас десятки подходов, которые позволяют сделать этот этап быстрее и лучше. Вот вам примерное направление мысли:

- Всего две статьи про использование сигнала из айтрекинга для rlhf (обе плохие).Вот бы была компания с мощнейшей нейронкой и огромной юзербазой айтрекеров в их виар шлемах

- НОЛЬ статей про использование имплицитных методов.

Тут не буду подробно распинаться, буквально миллионы долларов закопаны, надеюсь, кое-что сделаем в этой области на работе в ближайшее время.

Если вы им занимаетесь, то вот вам идея: наймите в команду когнитивного психолога. У нас десятки подходов, которые позволяют сделать этот этап быстрее и лучше. Вот вам примерное направление мысли:

- Всего две статьи про использование сигнала из айтрекинга для rlhf (обе плохие).

- НОЛЬ статей про использование имплицитных методов.

Тут не буду подробно распинаться, буквально миллионы долларов закопаны, надеюсь, кое-что сделаем в этой области на работе в ближайшее время.

Telegram

AI круто

Почему ChatGPT постоянно использует слово «delve»?

Всё началось с кеков: Пол Грэм твитнул что-то вроде «видишь бездушное письмо @ замечаешь, что в нём есть слово delve»

Илон Маск подтвердил.

Джереми Нгуен просканировал пабмед, и обнаружил, что упоминаемость…

Всё началось с кеков: Пол Грэм твитнул что-то вроде «видишь бездушное письмо @ замечаешь, что в нём есть слово delve»

Илон Маск подтвердил.

Джереми Нгуен просканировал пабмед, и обнаружил, что упоминаемость…

🫡3❤1🔥1

David Mayer

Имя и фамилия, которые ChatGPT отказывается произносить, и никто не знает, почему. Если вы попросите вам их повторить, чат вылетит с ошибкой. Если вы запишите их в виде головоломки, и попросите ГПТ её решить — он выкиинет ошибку. Если вы измените свои настройки персонализации... ну вы поняли.

Половина AI-твиттера сейчас бьётся над двумя загадками: как всё-таки заставить гпт произнести это имя, и почему, чёрт побери, она отказывается это делать?

Who is mr. Mayer?

Имя и фамилия, которые ChatGPT отказывается произносить, и никто не знает, почему. Если вы попросите вам их повторить, чат вылетит с ошибкой. Если вы запишите их в виде головоломки, и попросите ГПТ её решить — он выкиинет ошибку. Если вы измените свои настройки персонализации... ну вы поняли.

Половина AI-твиттера сейчас бьётся над двумя загадками: как всё-таки заставить гпт произнести это имя, и почему, чёрт побери, она отказывается это делать?

Who is mr. Mayer?

😱14