Coatue_AI_Revolution_115_ slides_Nov_2023.pdf

13.9 MB

VC фонд Coatue выложили свой взгляд про рынок AI, 115 слайдов:

- Их новый CEO был раньше всю жизнь CTO - оч необычно для VC/private equity такого масштаба

- Аналогии с эпохой мэйнфреймов, ПК, инета, мобайла, скорости adoption - интересные графики, оч быстро листается

- Наглядное разбиение на слои/типы стартапов/компаний в экосистеме + в тч упоминают некоторые их инвестиции

- Показывают как openAI становился все закрытее и коммерческее + что там по open source

- Показывают как регуляция EU соотносится с ключевыми foundational models

В целом смотрят супер макро, тк они оч большие - им надо вложить $15-20 млрд - это означает, грубо говоря, что на $50 млрд только оценка суммарной капитализации их портфеля на входе -> т.е. на выходе надо в неск раз больше -> поэтому они и смотрят сколько десятков-сотен млрд капитализации создали на прошлых мега волнах инноваций в разных слоях value chain:

- Производители чипов и сотовые операторы

- Clouds типа AWS Msft Goog

и

- SaaS игроки с продуктами для конечных юзеров

- Их новый CEO был раньше всю жизнь CTO - оч необычно для VC/private equity такого масштаба

- Аналогии с эпохой мэйнфреймов, ПК, инета, мобайла, скорости adoption - интересные графики, оч быстро листается

- Наглядное разбиение на слои/типы стартапов/компаний в экосистеме + в тч упоминают некоторые их инвестиции

- Показывают как openAI становился все закрытее и коммерческее + что там по open source

- Показывают как регуляция EU соотносится с ключевыми foundational models

В целом смотрят супер макро, тк они оч большие - им надо вложить $15-20 млрд - это означает, грубо говоря, что на $50 млрд только оценка суммарной капитализации их портфеля на входе -> т.е. на выходе надо в неск раз больше -> поэтому они и смотрят сколько десятков-сотен млрд капитализации создали на прошлых мега волнах инноваций в разных слоях value chain:

- Производители чипов и сотовые операторы

- Clouds типа AWS Msft Goog

и

- SaaS игроки с продуктами для конечных юзеров

👍9🔥4❤1

Forwarded from уровни абстракции

Пространство смыслов или как мыслит ИИ

ВЕКТОРНЫМ ПРЕДСТАВЛЕНИЕМ ТЕКСТА В 1000-МЕРНОМ ПРОСТРАНСТВЕ

Возможно, вы уже успели убедиться, что современный ИИ прекрасно воспринимает текстовую информацию — он "понимает" все, что вы ему напишете и "рассуждает" на уровне образованного собеседника. Однако удивительно мало внимания уделяется тому, как ИИ информацию обрабатывает и как образы, выраженные словами, превращаются в понятные машине нули и единицы. Серия постов, где я вместе с вами разбираюсь в возможностях и ограничениях GPT-подобных систем.

Начнем с того как воспринимаем информацию мы. Сознание человека привыкло оперировать словами и связанными с ними образами, позволяя нам складывать конструкции более высоких уровней абстракции. При этом помимо внутренней логики языка, мы осознаем логики причинно-следственных связей, эмоций и чувств, времени и пространства, звука, цвета и так далее. То есть наше сознание хотя и тексто-центрично, языком не исчерпывается (хотя философы на эту тему спорят).

ИИ не такой, кроме текста он не знает вообще ничего и только-только начинает добавлять в свою картину мира изображения. То есть он не понимает категории времени, но помнит все, что о времени было написано, например, с какой вероятностью после слова “время” встречается слово “идёт”, а с какой — “песок, время вода, скажи мне да”. И хотя интерфейсы для нашего взаимодействия с ИИ — это по сути слова, все расчеты в нейронных сетях сводятся к числам. Основой для "понимания" языка у ИИ являются не буквы и слова, а т.н. вектора в многомерном пространстве смыслов (vector embeddings). Поэтому при каждом запросе текст переносится в это пространство смыслов специального типа функцией (word2vec). Эту операцию можно представлять переводом с любого из человеческих языков на язык ИИ. В частном случае openAI у этого пространства 1536 измерений, у google - 768, но это детали. Главное здесь:

1. вектора в этом пространстве описывают все понятия и явлении, которые только могут быть выражены в языке

2. в том что для трехмерного сознания кожаных мешков размерность любого из этих пространств достаточно большое, чтобы не суметь осознать его примерно никогда. привет всем, кто пытался представить 4-мерый куб.

3. несмотря на семантическую природу пространства и привязку к языку, все операции над текстов сводятся к математическим операциям над векторами. их можно складывать и это равносильно сложению смысла слов в предложениях, или умножать — их скалярное произведение описывает, насколько два текста на любом из человеческих языков близки по смыслу между собой. причем для таких расчетов машине больше не нужно ничего "понимать", нужно (заткнуться) и считать.

Например, так выглядит слово “кот” в гугловском пространстве, определенном функцией BERT (фото 1).

Каждая координата этого вектора - число с плавающей точкой (float), которое уже записывается в память компьютера и занимает там 4 байта.

- Каждый такой вектор занимает 4 байта х размерность 768 = 3 кБ

- При этом слово занимает 2 байта на символ UTF-8 х 3 буквы в слове “кот” = 6 Б

Разница в 500 раз. Векторная запись одного слова занимаете памяти как целая страница текста. Дело в том, что помимо самого слова в нем хранится информация о понятии “кот” — сколько у него лап, какие он издает звуки и все, что нашлось в обучающей выборки, точнее какие слова встречались рядом со словом "кот" в текстах обучающей выборки .

Чудо в том, что после всех операций и обратной конвертации этих векторов на человеческий, получаются тексты связные не только на уровне последовательностей слов, но и на уровне причинно-следственных связей, о которых машина не имеет никакого представления. И чудо это заключено в конкретном способе трансформации текста в векторы, в количестве измерений и различных способах оптимизации. И уже существующие способы, хотя и хороши, все еще может быть улучшены значительно (до 40%). И это одна из точек активного приложения усилий ИИ-исследователей прямо сейчас.

Ссылки:

1. Демо - уровень абстракции #1 - скрины отсюда ниже

2. Как работает Google BERT

3. Документация openAI

Возможно, вы уже успели убедиться, что современный ИИ прекрасно воспринимает текстовую информацию — он "понимает" все, что вы ему напишете и "рассуждает" на уровне образованного собеседника. Однако удивительно мало внимания уделяется тому, как ИИ информацию обрабатывает и как образы, выраженные словами, превращаются в понятные машине нули и единицы. Серия постов, где я вместе с вами разбираюсь в возможностях и ограничениях GPT-подобных систем.

Начнем с того как воспринимаем информацию мы. Сознание человека привыкло оперировать словами и связанными с ними образами, позволяя нам складывать конструкции более высоких уровней абстракции. При этом помимо внутренней логики языка, мы осознаем логики причинно-следственных связей, эмоций и чувств, времени и пространства, звука, цвета и так далее. То есть наше сознание хотя и тексто-центрично, языком не исчерпывается (хотя философы на эту тему спорят).

ИИ не такой, кроме текста он не знает вообще ничего и только-только начинает добавлять в свою картину мира изображения. То есть он не понимает категории времени, но помнит все, что о времени было написано, например, с какой вероятностью после слова “время” встречается слово “идёт”, а с какой — “песок, время вода, скажи мне да”. И хотя интерфейсы для нашего взаимодействия с ИИ — это по сути слова, все расчеты в нейронных сетях сводятся к числам. Основой для "понимания" языка у ИИ являются не буквы и слова, а т.н. вектора в многомерном пространстве смыслов (vector embeddings). Поэтому при каждом запросе текст переносится в это пространство смыслов специального типа функцией (word2vec). Эту операцию можно представлять переводом с любого из человеческих языков на язык ИИ. В частном случае openAI у этого пространства 1536 измерений, у google - 768, но это детали. Главное здесь:

1. вектора в этом пространстве описывают все понятия и явлении, которые только могут быть выражены в языке

2. в том что для трехмерного сознания кожаных мешков размерность любого из этих пространств достаточно большое, чтобы не суметь осознать его примерно никогда. привет всем, кто пытался представить 4-мерый куб.

3. несмотря на семантическую природу пространства и привязку к языку, все операции над текстов сводятся к математическим операциям над векторами. их можно складывать и это равносильно сложению смысла слов в предложениях, или умножать — их скалярное произведение описывает, насколько два текста на любом из человеческих языков близки по смыслу между собой. причем для таких расчетов машине больше не нужно ничего "понимать", нужно (заткнуться) и считать.

Например, так выглядит слово “кот” в гугловском пространстве, определенном функцией BERT (фото 1).

Каждая координата этого вектора - число с плавающей точкой (float), которое уже записывается в память компьютера и занимает там 4 байта.

- Каждый такой вектор занимает 4 байта х размерность 768 = 3 кБ

- При этом слово занимает 2 байта на символ UTF-8 х 3 буквы в слове “кот” = 6 Б

Разница в 500 раз. Векторная запись одного слова занимаете памяти как целая страница текста. Дело в том, что помимо самого слова в нем хранится информация о понятии “кот” — сколько у него лап, какие он издает звуки и все, что нашлось в обучающей выборки, точнее какие слова встречались рядом со словом "кот" в текстах обучающей выборки .

Чудо в том, что после всех операций и обратной конвертации этих векторов на человеческий, получаются тексты связные не только на уровне последовательностей слов, но и на уровне причинно-следственных связей, о которых машина не имеет никакого представления. И чудо это заключено в конкретном способе трансформации текста в векторы, в количестве измерений и различных способах оптимизации. И уже существующие способы, хотя и хороши, все еще может быть улучшены значительно (до 40%). И это одна из точек активного приложения усилий ИИ-исследователей прямо сейчас.

Ссылки:

1. Демо - уровень абстракции #1 - скрины отсюда ниже

2. Как работает Google BERT

3. Документация openAI

👍16❤2❤🔥1

Паника про т.н. AGI захлестывает и наш social bubble, и техно-сегмент в X. Доползло и до законодателей США с риском на эпический regulatory capture/фиаско госуправления в пользу bigtech, или в Китае, или в Европе (там давно лобби Future of Life Institute от моего [уже менее 🙈] любимого Max Tegmark)

Каждый алармист - это один или несколько пунктов:

1. Ира Якутенко круто заметила, что современный мир стал слишком безопасен, а наши гены к этому не адаптировались, и поэтому в популяции есть люди, которые создают угрозы буквально на пустом месте, и что их можно отличить по самоназванию: people who care/“кому не все равно”

- Это, e.g., Бенджио, Хинтон итп академические подписанты призыва к полугодовому [естественно, не сработавшему] мораторию на AI research

- Маск тоже подписал в марте, но уже в апреле закупился GPU на сотни млн $, а в ноябре релизнул свою LLM xAI/Grok

2. Peter Thiel вообще не тратит время: “страх AGI вытекает всего лишь из взглядов на мир как дарвиниста или макиавеллиста”

- (дарвинизм - что главным фактором эволюции является естественный отбор)

- (макиавеллизм - политика только на основе грубой силы, пренебрегая моралью)

3. Разные модели идеального социума

- Боятся люди, кто не видел смену многих технологических укладов (Vinod Khosla считает, что нас ждут AI врачи/преподы/юристы, 1 млрд программистов на естественном языке, 1 млн двуногих роботов через 10 лет итп) или не руководили большими коллективами/не общались с governments по миру (как Bill Gates, который считает, что AI даст нам 3-ехдневную рабочую неделю)

а

- Рафинированные теоретичные люди с quirky фантазиями о том, как должен быть устроен идеальный, на их взгляд, социум. Типа той девочки на борде OpenAI, замутившей всю эту бучу во имя EA/effective alltruism, или, как заметил Yann LeCun “не тренировавший ни одной нейронки Иелезар Юдковский”, или депрессивный философ Ник Бостром

4. Страх AI - это современная форма анимизма, считает либертарианский философ Gaspard Koenig, автор книги 2019 г “Конец индивидуума” (после нее он потерял всякий интерес к AI)

- Пример: Сергей Карелов, называющим всякие (пока) неизвестные феномены computational irreducibility запугивающим образом типа “форма НЕчеловеческого интеллекта уже на Земле” 🙈

5. Слишком большая опора на материализм [западнической цивилизации] вытесняет из психики части души, требующих опору на трансцендентное

- Но эти фичи мозга никуда не деваются и идут на страхи и второго пришествия, и апокалипсиса вместе взятых, пусть и замаскированные в псевдо-рацио AGI. В AGI safety гипотезы пока - спекулятивные и/или нет экспериментов чтобы их отвергнуть (фальсифицируемость Поппера, по меркам естественных наук это не самые научные теории)

6. Лично непроработанные страхи, тк не было личной психотерапии (или была, но не доделали)

- Разбор своих, случайно набранных в детстве страхов/импринтов (можно к моей Юле обращаться, она оч теплый и бережный психолог про подсознание):

а) позволяет видеть мир реалистичнее, доступно большее пространство для действий

б) высвобождает затрачиваемые на страх ресурсы души

в) поправляет локус контроля куда там мир идет, снижает батхерт на посты типа этого, “как Витя не понимает, есть же вероятность исчезновения человечества!!”

Что еще?

Upd:

Женя Кузнецов красиво назвал эффективных альтруистов термином «оксфордский комсомол» 🙈 в своей статье в Форбс, в тч про обширное лобби структур Дастина Московица (в рамках effective altruism сделал Open Philanthropy) в Вашингтоне

Каждый алармист - это один или несколько пунктов:

1. Ира Якутенко круто заметила, что современный мир стал слишком безопасен, а наши гены к этому не адаптировались, и поэтому в популяции есть люди, которые создают угрозы буквально на пустом месте, и что их можно отличить по самоназванию: people who care/“кому не все равно”

- Это, e.g., Бенджио, Хинтон итп академические подписанты призыва к полугодовому [естественно, не сработавшему] мораторию на AI research

- Маск тоже подписал в марте, но уже в апреле закупился GPU на сотни млн $, а в ноябре релизнул свою LLM xAI/Grok

2. Peter Thiel вообще не тратит время: “страх AGI вытекает всего лишь из взглядов на мир как дарвиниста или макиавеллиста”

- (дарвинизм - что главным фактором эволюции является естественный отбор)

- (макиавеллизм - политика только на основе грубой силы, пренебрегая моралью)

3. Разные модели идеального социума

- Боятся люди, кто не видел смену многих технологических укладов (Vinod Khosla считает, что нас ждут AI врачи/преподы/юристы, 1 млрд программистов на естественном языке, 1 млн двуногих роботов через 10 лет итп) или не руководили большими коллективами/не общались с governments по миру (как Bill Gates, который считает, что AI даст нам 3-ехдневную рабочую неделю)

а

- Рафинированные теоретичные люди с quirky фантазиями о том, как должен быть устроен идеальный, на их взгляд, социум. Типа той девочки на борде OpenAI, замутившей всю эту бучу во имя EA/effective alltruism, или, как заметил Yann LeCun “не тренировавший ни одной нейронки Иелезар Юдковский”, или депрессивный философ Ник Бостром

4. Страх AI - это современная форма анимизма, считает либертарианский философ Gaspard Koenig, автор книги 2019 г “Конец индивидуума” (после нее он потерял всякий интерес к AI)

- Пример: Сергей Карелов, называющим всякие (пока) неизвестные феномены computational irreducibility запугивающим образом типа “форма НЕчеловеческого интеллекта уже на Земле” 🙈

5. Слишком большая опора на материализм [западнической цивилизации] вытесняет из психики части души, требующих опору на трансцендентное

- Но эти фичи мозга никуда не деваются и идут на страхи и второго пришествия, и апокалипсиса вместе взятых, пусть и замаскированные в псевдо-рацио AGI. В AGI safety гипотезы пока - спекулятивные и/или нет экспериментов чтобы их отвергнуть (фальсифицируемость Поппера, по меркам естественных наук это не самые научные теории)

6. Лично непроработанные страхи, тк не было личной психотерапии (или была, но не доделали)

- Разбор своих, случайно набранных в детстве страхов/импринтов (можно к моей Юле обращаться, она оч теплый и бережный психолог про подсознание):

а) позволяет видеть мир реалистичнее, доступно большее пространство для действий

б) высвобождает затрачиваемые на страх ресурсы души

в) поправляет локус контроля куда там мир идет, снижает батхерт на посты типа этого, “как Витя не понимает, есть же вероятность исчезновения человечества!!”

Что еще?

Upd:

Женя Кузнецов красиво назвал эффективных альтруистов термином «оксфордский комсомол» 🙈 в своей статье в Форбс, в тч про обширное лобби структур Дастина Московица (в рамках effective altruism сделал Open Philanthropy) в Вашингтоне

👍12❤3😁2🤔2🦄1

Люди работают в растущих стартапах или бигтехах (правда среди общей массы юникорнов доля фаундеров кто выходцы из бигтехов небольшая) и видят, что не боги горшки обжигают и постоянно идут пилить свои проекты

У некоторых VC часть инвесттезиса - готовы вкладываться в выходцев из уже успешных стартапов в их портфелях, кто решает идти в фаундерство

У некоторых VC часть инвесттезиса - готовы вкладываться в выходцев из уже успешных стартапов в их портфелях, кто решает идти в фаундерство

This media is not supported in your browser

VIEW IN TELEGRAM

Илон Маск поделился мнением по поводу шантажа его рекламодателями в его Твиттере/X по поводу его якобы антисемитизма 🙈

❤3🔥2❤🔥1

Forwarded from Boi diaries

DeepMind, возможно, снова резко пнули кинули двинули (!) науку вперёд (как с AlphaFold):

представили GNoME (Graph Networks for Material Exploration)

1) Это графовая сетка, способная не только предсказывать кристаллические структуры материалов, но и их стабильность

2) Все найденные материалы (а их уже, по словам ДМ, 380,000 - стабильных, и 2.2 млн всего) будут выложены в открытый доступ

3) За последнеи десять лет вычислительным путём было найдено около 28 тысяч стабильных кристаллических структур ⇒ то есть DM, по их подсчётам, набросал эквивалент ~800 лет ресерча

4) Среди обнаруженного - 52,000 потенциально новых структур графен-подобных материалов (сверхпроводники), 528 аналогов литиевых проводников (аккумуляторы)

5) Состоит из двух путей: структурного (аналоги известных материалов) и композиционного (~рандомная генерация) ➟ проверка на стабильность ➟ дальнейшая проверка (Density Functional Theory)

📚 Папира

🎥 Минутный видос - дашборд, как люди заходили и использовали БД с материалами (чут чуткусат завораживает)

📚 Беркли делает лабу для автономного синтеза материалов. Выглядит модно, и за 17 дней эксперимента насинтезировала 41/58 материалов - для сравнения, человеку могут потребоваться недели-месяцы на один материал(особенно когда нет финансирования...)

представили GNoME (Graph Networks for Material Exploration)

1) Это графовая сетка, способная не только предсказывать кристаллические структуры материалов, но и их стабильность

2) Все найденные материалы (а их уже, по словам ДМ, 380,000 - стабильных, и 2.2 млн всего) будут выложены в открытый доступ

3) За последнеи десять лет вычислительным путём было найдено около 28 тысяч стабильных кристаллических структур ⇒ то есть DM, по их подсчётам, набросал эквивалент ~800 лет ресерча

4) Среди обнаруженного - 52,000 потенциально новых структур графен-подобных материалов (сверхпроводники), 528 аналогов литиевых проводников (аккумуляторы)

5) Состоит из двух путей: структурного (аналоги известных материалов) и композиционного (~рандомная генерация) ➟ проверка на стабильность ➟ дальнейшая проверка (Density Functional Theory)

📚 Папира

🎥 Минутный видос - дашборд, как люди заходили и использовали БД с материалами (чут чут

📚 Беркли делает лабу для автономного синтеза материалов. Выглядит модно, и за 17 дней эксперимента насинтезировала 41/58 материалов - для сравнения, человеку могут потребоваться недели-месяцы на один материал

❤5🔥5

Ray Kurzweil, ему 75 лет, автор книг про сингулярность с конца 1990х (The Age of Spiritual Machines), в июне 2024 выпустит книгу The Singularity is Nearer - апдейт его прогноза 1999 года, что к 2029 компьютеры превзойдут человеческий уровень intelligence. Вроде можно даже ее с его автографом заказать, в США бесплатно. Он формулирует, что “We will see as much progress in the decade ahead (2023 – 2033) as we have seen in the past century (1923 – 2023).”

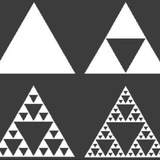

Мне кажется, или мы наблюдаем эффект как в картинке этого поста? 🙈

Upd: Прочитал в августе 2024, вот мой конспект. Ерунда, Рэй за 25 лет с первой книги про singularity ничего нового не добавил ((

Мне кажется, или мы наблюдаем эффект как в картинке этого поста? 🙈

Upd: Прочитал в августе 2024, вот мой конспект. Ерунда, Рэй за 25 лет с первой книги про singularity ничего нового не добавил ((

❤5🔥2❤🔥1💯1🦄1

1963 год (!). Ничего не напоминает? 🙈🙈🙈 Автор теории AI между прочим ) (Норберт Винер)

… о социальных последствиях автоматизации:

Представим себе, что вторая революция завершена. Тогда средний человек со средними или ещё меньшими способностями не сможет предложить для продажи ничего, за что стоило бы платить деньги.

… о социальных последствиях автоматизации:

Представим себе, что вторая революция завершена. Тогда средний человек со средними или ещё меньшими способностями не сможет предложить для продажи ничего, за что стоило бы платить деньги.

🤔9🔥8💯8❤🔥1❤1

Примерный путь к типичному юникорну с т.зр.:

- масштабов выручки в год,

- темпов ее роста от месяца к месяцу (три сценария - крутой, средний и "не очень”),

- и примерные оценки на раундах по мере этого роста (данные Carta)

И видно, как именно снижается multiple оценки по отношению к выручке по мере роста выручки в абсолютном выражении.

Это примерно на 2023q3 данные.

И если сравнить индекс для публичных SaaS компаний, то видно что late stage инвесторы сейчас хотят 1.5-2x апсайда на свои инвестиции по отношению к сегодняшнему 6x revenue multiple для публичных компаний.

Общая механика такая примерно

На последней картинке видно что late stage с пиков 2021 г оценка упала с $340 до $170 млн для Series C и c $800 до $220 млн для Series D

Seed причем не снижается 🙈🙈 (я же на ангельской и pre-seed/seed стадии вкладываюсь)

- масштабов выручки в год,

- темпов ее роста от месяца к месяцу (три сценария - крутой, средний и "не очень”),

- и примерные оценки на раундах по мере этого роста (данные Carta)

И видно, как именно снижается multiple оценки по отношению к выручке по мере роста выручки в абсолютном выражении.

Это примерно на 2023q3 данные.

И если сравнить индекс для публичных SaaS компаний, то видно что late stage инвесторы сейчас хотят 1.5-2x апсайда на свои инвестиции по отношению к сегодняшнему 6x revenue multiple для публичных компаний.

Общая механика такая примерно

На последней картинке видно что late stage с пиков 2021 г оценка упала с $340 до $170 млн для Series C и c $800 до $220 млн для Series D

Seed причем не снижается 🙈🙈 (я же на ангельской и pre-seed/seed стадии вкладываюсь)

🔥2

https://bbycroft.net/llm - тут можно в анимации посмотреть визуализацию, как работает LLM на 80 тыс параметров ) (нужно с компа, с телефона не получится)

👍9❤1

В YC откат на 4 года назад по числу стартапов в бетчах

Carta считают, что за следующий год ситуация будет начинать возвращаться к конверсиям, что были раньше

Carta считают, что за следующий год ситуация будет начинать возвращаться к конверсиям, что были раньше

Чет все же реально никто ничего не знает про будущее. Это рынки фьючерсов (куча агентов, все умные, десятки трлн активов под управлением) про ставку ФРС. а черная линия - какая ставка была в итоге

- То есть долг экономики США рос, и рынки с 2010 6 лет ждали повышения ставки, и не фига

- В 2019 ожидали ее сохранения, а ее снизили (ДО короны, обратите внимание - в корону вообще обнулили)

- В 2022 ставку подняли выше ожиданий вообще всех абсолютно

- ОК, теперь ждем спустя год с каким темпом ФРС ставку снижать/поддерживать будут =)))

UPD1 график отсюда

UPD2 Рэй Далио оч крутой если делал свои 10%/год на макро bets + и на своем адском масштабе в $100 млрд активов под управлением

UPD3 Тут хренову ставку ФРС никто предсказать не может, какие уж тут нафиг прогнозы про опасность AI 🙈🙈😂😂

- То есть долг экономики США рос, и рынки с 2010 6 лет ждали повышения ставки, и не фига

- В 2019 ожидали ее сохранения, а ее снизили (ДО короны, обратите внимание - в корону вообще обнулили)

- В 2022 ставку подняли выше ожиданий вообще всех абсолютно

- ОК, теперь ждем спустя год с каким темпом ФРС ставку снижать/поддерживать будут =)))

UPD1 график отсюда

UPD2 Рэй Далио оч крутой если делал свои 10%/год на макро bets + и на своем адском масштабе в $100 млрд активов под управлением

UPD3 Тут хренову ставку ФРС никто предсказать не может, какие уж тут нафиг прогнозы про опасность AI 🙈🙈😂😂

💯5👍3